Tăng tốc Qwen3-8B Agent trên Intel® Core™ Ultra với các Mô hình Nháp được Cắt tỉa Độ sâu

- 7 min read

Tăng tốc Qwen3-8B Agent trên Intel® Core™ Ultra với các Mô hình Nháp được Tỉa Bớt Độ Sâu

TL;DR:

- Qwen3-8B là một trong những bản phát hành thú vị gần đây nhất—một mô hình có khả năng agentic gốc, làm cho nó phù hợp tự nhiên với AIPC.

- Với OpenVINO.GenAI, chúng tôi đã có thể tăng tốc độ tạo bằng ~1.3 lần bằng cách sử dụng giải mã suy đoán với bản nháp Qwen3-0.6B nhẹ.

- Bằng cách sử dụng giải mã suy đoán và áp dụng một quy trình cắt tỉa đơn giản cho bản nháp, chúng tôi đã đẩy nhanh tốc độ lên ~1.4 lần.

- Chúng tôi đã gói gọn điều này bằng cách chỉ ra cách những cải tiến này có thể được sử dụng để chạy một AI Agent cục bộ, nhanh chóng với 🤗 smolagents

Qwen3

Qwen3-8B là một phần của dòng Qwen mới nhất, được đào tạo với các hành vi agentic rõ ràng. Nó hỗ trợ gọi công cụ, suy luận nhiều bước và khả năng xử lý ngữ cảnh dài, giúp nó phù hợp với các quy trình làm việc của agent phức tạp. Khi được tích hợp với các framework như Hugging Face 🤗smolagents, QwenAgent hoặc AutoGen, nó cho phép một loạt các ứng dụng agentic được xây dựng xung quanh việc sử dụng công cụ và suy luận. Không giống như chatbot một lượt, các ứng dụng agentic dựa trên các mô hình suy luận tạo ra các dấu vết “suy nghĩ thành tiếng”, các bước trung gian mở rộng việc sử dụng token, làm cho tốc độ suy luận trở nên quan trọng đối với khả năng phản hồi. Sự kết hợp giữa suy luận được tối ưu hóa và trí thông minh agentic tích hợp làm cho Qwen3-8B trở thành một nền tảng hấp dẫn cho các AI agent thế hệ tiếp theo.

Tăng tốc Qwen3-8B trên Intel® Core™ Ultra với Giải mã Suy đoán

Chúng tôi bắt đầu bằng cách đánh giá phiên bản OpenVINO được tối ưu hóa 4-bit của Qwen3-8B trên GPU tích hợp Intel Lunar Lake, thiết lập điều này làm cơ sở để tăng tốc hơn nữa

Giải mã suy đoán là một phương pháp để tăng tốc độ tạo tự hồi quy. Nó hoạt động bằng cách sử dụng một mô hình nhỏ hơn, nhanh hơn làm bản nháp để đề xuất nhiều token trong một lần chuyển tiếp duy nhất, sau đó được mô hình mục tiêu lớn hơn xác thực trong một lần chuyển tiếp. Trong thiết lập của chúng tôi, Qwen3-8B đóng vai trò là mô hình mục tiêu trong khi Qwen3-0.6B được sử dụng làm bản nháp. Cách tiếp cận này mang lại tốc độ tăng trung bình 1.3 lần so với đường cơ sở.

python from openvino_genai import LLMPipeline, draft_model

target_path = “/path/to/target/Qwen3-8B-int4-ov” draft_path = “/path/to/draft/Qwen3-0.6B-int8-ov” device = “GPU”

model = LLMPipeline(target_path, device, draft_model=draft_model(draft_path, device))

streamer = lambda x: print(x, end="", flush=True) model.generate(“What is speculative decoding and how does it improve inference speed?”, max_new_tokens=100, reamer=streamer)

Trước khi khởi tạo

LLMPipeline, hãy đảm bảo cả mô hình mục tiêu và mô hình nháp đều được chuyển đổi sang OpenVINO. Bạn có thể tải xuống các mô hình đã chuyển đổi trước từ các liên kết được cung cấp hoặc làm theo các hướng dẫn này để chuyển đổi các mô hình của riêng bạn.

Đẩy mạnh hiệu suất hơn nữa

Tốc độ tăng tốc giải mã suy đoán phụ thuộc vào số lượng trung bình các token được tạo trên mỗi bước chuyển tiếp của mục tiêu, γ \gamma γ, kích thước cửa sổ suy đoán và tỷ lệ giữa độ trễ của các mô hình mục tiêu và mô hình nháp c c c. Một bản nháp nhỏ hơn, nhanh hơn (mặc dù kém chính xác hơn) thường có thể mang lại khả năng tăng tốc lớn hơn. Điều này đã truyền cảm hứng cho chúng tôi thu nhỏ mô hình nháp trong khi vẫn duy trì chất lượng của nó, tức là E(#generatedtokens) E(# generated_tokens) E(#generatedtokens).

Speedup=E(#generatedtokens)γc+1 Speedup = \frac{E(# generated_tokens)}{\gamma c + 1} Speedup=γc+1E(#generatedtokens)

Công trình gần đây của chúng tôi cho thấy độ sâu mô hình (số lớp) là một yếu tố chính gây ra độ trễ suy luận. Chúng tôi đã lấy cảm hứng từ công việc gần đây về nén theo lớp [1]. Trong phương pháp của chúng tôi, chúng tôi xác định các khối lớp đóng góp rất ít, được đo bằng khoảng cách góc và loại bỏ chúng. Sau khi cắt tỉa, chúng tôi áp dụng tinh chỉnh để phục hồi độ chính xác. Sử dụng phương pháp này, chúng tôi đã cắt tỉa 6 trong số 28 lớp từ mô hình nháp Qwen3-0.6B. Để khôi phục chất lượng của mô hình nháp đã cắt tỉa, chúng tôi tiếp tục tinh chỉnh nó bằng dữ liệu tổng hợp do Qwen3-8B tạo ra. Dữ liệu được tạo ra bằng cách tạo phản hồi cho 500 nghìn lời nhắc từ tập dữ liệu BAAI/Infinity-Instruct.

Mô hình nháp đã cắt tỉa thu được tốc độ tăng ~1.4x so với đường cơ sở, một cải tiến so với mức tăng ~1.3× đạt được với bản nháp ban đầu. Kết quả này phù hợp với những kỳ vọng về mặt lý thuyết - giảm độ trễ bản nháp sẽ cải thiện tốc độ tăng tốc tổng thể, cho phép suy luận nhanh hơn và hiệu quả hơn.

Điều này chứng minh cách cắt tỉa + giải mã suy đoán có thể mở ra suy luận nhanh hơn và hiệu quả hơn—làm cho các AI agent cục bộ trở nên thiết thực hơn.

Hãy xem notebook và mô hình nháp đã cắt tỉa độ sâu Qwen3-0.6B để tái tạo kết quả của chúng tôi từng bước

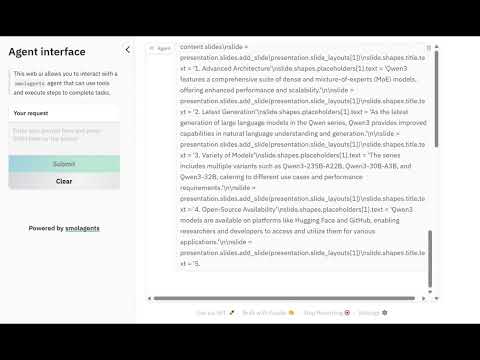

Tích hợp với 🤗smolagents

Để giới thiệu tiềm năng thực tế, chúng tôi đã triển khai thiết lập được tối ưu hóa của mình với thư viện 🤗smolagents. Với sự tích hợp này, các nhà phát triển có thể cắm Qwen3-8B (kết hợp với bản nháp đã cắt tỉa của chúng tôi) để xây dựng các agent gọi API và các công cụ bên ngoài, viết và thực thi mã, xử lý suy luận ngữ cảnh dài và chạy hiệu quả trên Intel® Core™ Ultra. Lợi ích không giới hạn ở Hugging Face, việc ghép nối mô hình này cũng có thể được sử dụng liền mạch với các framework như AutoGen hoặc QwenAgent, tăng cường hơn nữa hệ sinh thái agentic.

Trong bản demo của chúng tôi, chúng tôi đã giao cho agent dựa trên Qwen3 được tăng tốc một nhiệm vụ: 👉 Tóm tắt các tính năng chính của dòng mô hình Qwen3 và trình bày chúng trong một bộ slide.

Đây là cách nó hoạt động:

- Agent đã sử dụng một công cụ tìm kiếm web để thu thập thông tin cập nhật.

- Sau đó, nó chuyển sang trình thông dịch Python để tạo slide với thư viện

python-pptx.

Quy trình làm việc đơn giản này chỉ làm nổi bật một phần nhỏ trong số các khả năng được mở khóa khi các mô hình Qwen3 được tăng tốc đáp ứng các framework như 🤗smolagents, mang lại các AI agent thực tế, hiệu quả vào cuộc sống trên AI PC. Hãy thử nó ở đây 🚀

Tài liệu tham khảo

[1] Gromov, A., Tirumala, K., Shapourian, H., Glorioso, P., & Roberts, D. A. (2025, January 22). Tính không hiệu quả phi lý của các lớp sâu hơn. Áp phích được trình bày tại ICLR 2025. https://arxiv.org/abs/2403.17887

Thông báo về hiệu suất và pháp lý

- Kết quả hiệu suất dựa trên các điểm chuẩn nội bộ với OpenVINO™ 2025.2 kể từ tháng 9 năm 2025, sử dụng cấu hình với bộ xử lý Intel® Core™ Ultra 7 268V 2.20 GHz với GPU Intel® Arc™ 140V tích hợp, kết hợp với bộ nhớ DDR5 32 GB.

- Hiệu suất thay đổi theo cách sử dụng, cấu hình và các yếu tố khác. Tìm hiểu thêm tại www.Intel.com/PerformanceIndex.

- Không có sản phẩm hoặc thành phần nào có thể hoàn toàn an toàn.

- Chi phí và kết quả của bạn có thể khác nhau.

- Công nghệ Intel có thể yêu cầu phần cứng, phần mềm hoặc kích hoạt dịch vụ được bật.

- © Intel Corporation. Intel, logo Intel và các nhãn hiệu khác của Intel là thương hiệu của Intel Corporation hoặc các công ty con của nó.

- Các tên và thương hiệu khác có thể được tuyên bố là tài sản của người khác.